معرفی مختصر آمار و احتمال

|

|---|

| آمار و احتمال - یادداشت طراحی شده توسط @nitya |

آمار و نظریه احتمال دو حوزه بسیار مرتبط از ریاضیات هستند که به شدت با علم داده مرتبط هستند. امکان کار با دادهها بدون دانش عمیق ریاضیات وجود دارد، اما همچنان بهتر است حداقل برخی از مفاهیم پایه را بدانید. در اینجا یک معرفی کوتاه ارائه میکنیم که به شما کمک میکند شروع کنید.

آزمون قبل از سخنرانی

احتمال و متغیرهای تصادفی

احتمال یک عدد بین 0 و 1 است که بیان میکند یک رویداد چقدر محتمل است. این عدد به عنوان تعداد نتایج مثبت (که منجر به رویداد میشوند)، تقسیم بر تعداد کل نتایج، با فرض اینکه همه نتایج به یک اندازه محتمل هستند، تعریف میشود. برای مثال، وقتی یک تاس میاندازیم، احتمال اینکه عدد زوج بیاوریم 3/6 = 0.5 است.

وقتی در مورد رویدادها صحبت میکنیم، از متغیرهای تصادفی استفاده میکنیم. برای مثال، متغیر تصادفی که عدد به دست آمده هنگام انداختن تاس را نشان میدهد، میتواند مقادیر 1 تا 6 را بگیرد. مجموعه اعداد از 1 تا 6 به عنوان فضای نمونه نامیده میشود. میتوانیم در مورد احتمال اینکه یک متغیر تصادفی یک مقدار مشخص را بگیرد صحبت کنیم، برای مثال P(X=3)=1/6.

متغیر تصادفی در مثال قبلی گسسته نامیده میشود، زیرا یک فضای نمونه قابل شمارش دارد، یعنی مقادیر جداگانهای وجود دارد که میتوان آنها را شمارش کرد. مواردی وجود دارد که فضای نمونه یک محدوده از اعداد واقعی یا کل مجموعه اعداد واقعی است. چنین متغیرهایی پیوسته نامیده میشوند. یک مثال خوب زمان رسیدن اتوبوس است.

توزیع احتمال

در مورد متغیرهای تصادفی گسسته، توصیف احتمال هر رویداد با یک تابع P(X) آسان است. برای هر مقدار s از فضای نمونه S، یک عدد از 0 تا 1 میدهد، به طوری که مجموع تمام مقادیر P(X=s) برای همه رویدادها 1 باشد.

معروفترین توزیع گسسته، توزیع یکنواخت است، که در آن یک فضای نمونه از N عنصر با احتمال برابر 1/N برای هر یک از آنها وجود دارد.

توصیف توزیع احتمال یک متغیر پیوسته، با مقادیر گرفته شده از یک بازه [a,b] یا مجموعه اعداد حقیقی ℝ، دشوارتر است. به عنوان مثال، زمان رسیدن اتوبوس را در نظر بگیرید. در واقع، برای هر زمان دقیق رسیدن t، احتمال رسیدن اتوبوس دقیقاً در آن زمان 0 است!

اکنون شما میدانید که رویدادهایی با احتمال 0 اتفاق میافتند و بسیار هم رایج هستند! حداقل هر بار که اتوبوس میرسد!

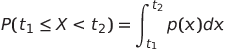

ما فقط میتوانیم در مورد احتمال قرار گرفتن یک متغیر در یک بازه مشخص از مقادیر صحبت کنیم، به عنوان مثال P(t1 ≤X<t2). در این صورت، توزیع احتمال توسط یک تابع چگالی احتمال p(x) توصیف میشود، به طوری که

یک آنالوگ پیوسته از توزیع یکنواخت، یکنواخت پیوسته نامیده میشود که در یک بازه محدود تعریف میشود. احتمال اینکه مقدار X در یک بازه به طول l قرار گیرد، با l متناسب است و تا 1 افزایش مییابد.

توزیع مهم دیگری که وجود دارد، توزیع نرمال است که در ادامه بیشتر در مورد آن صحبت خواهیم کرد.

میانگین، واریانس و انحراف معیار

فرض کنید ما یک دنباله از n نمونه از یک متغیر تصادفی X را میکشیم: x1, x2, ..., xn. ما میتوانیم میانگین (یا میانگین حسابی) دنباله را به روش سنتی به صورت (x1+x2+xn)/n تعریف کنیم. با افزایش اندازه نمونه (یعنی گرفتن حد با n→∞)، میانگین (که به آن انتظار نیز گفته میشود) توزیع را به دست میآوریم. ما انتظار را با E(x) نشان میدهیم.

میتوان نشان داد که برای هر توزیع گسسته با مقادیر {x1, x2, ..., xN} و احتمالهای متناظر p1, p2, ..., pN، انتظار برابر با E(X)=x1p1+x2 p2+...+xNpN خواهد بود.

برای شناسایی میزان پراکندگی مقادیر، میتوانیم واریانس σ2 = ∑(xi - μ)2/n را محاسبه کنیم، جایی که μ میانگین دنباله است. مقدار σ به عنوان انحراف معیار نامیده میشود و σ 2 به عنوان واریانس شناخته میشود.

مد، میانه و چارکها

گاهی اوقات، میانگین به طور مناسب "مقدار معمول" را برای دادهها نشان نمیدهد. به عنوان مثال، هنگامی که چند مقدار شدید وجود دارد که کاملاً خارج از محدوده هستند، میتوانند بر میانگین تأثیر بگذارند. شاخص خوب دیگر میانه است، مقداری که نیمی از نقاط داده کمتر از آن و نیمی دیگر بیشتر از آن هستند.

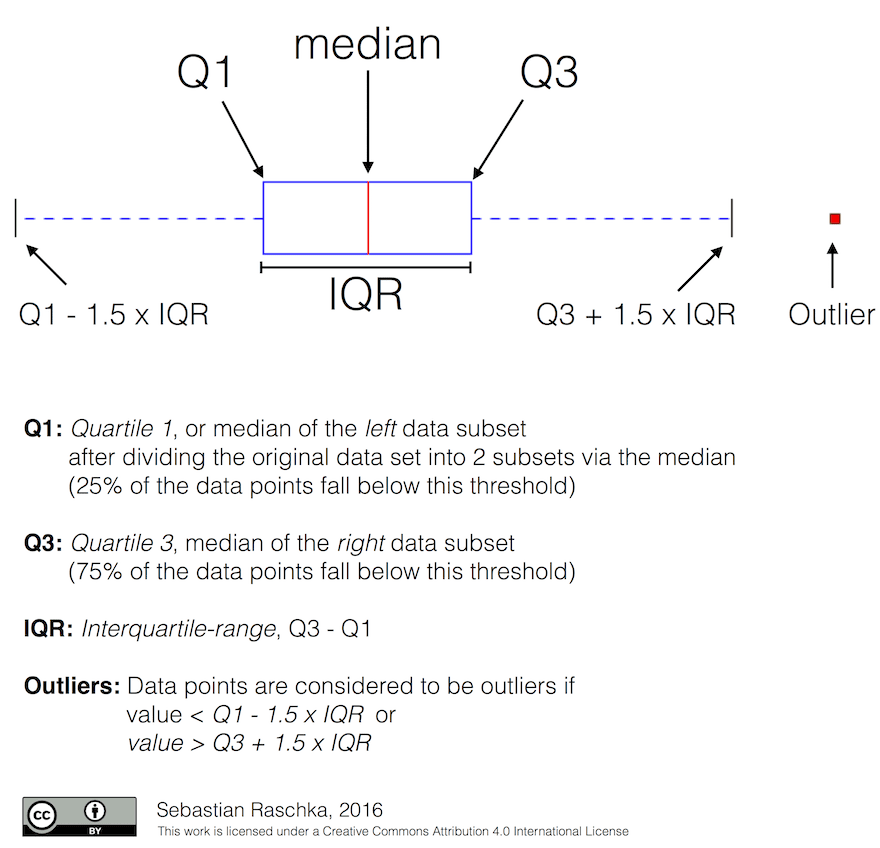

برای کمک به درک توزیع دادهها، صحبت در مورد چارکها مفید است:

- چارک اول، یا Q1، مقداری است که 25٪ از دادهها زیر آن قرار میگیرند

- چارک سوم، یا Q3، مقداری است که 75٪ از دادهها زیر آن قرار میگیرند

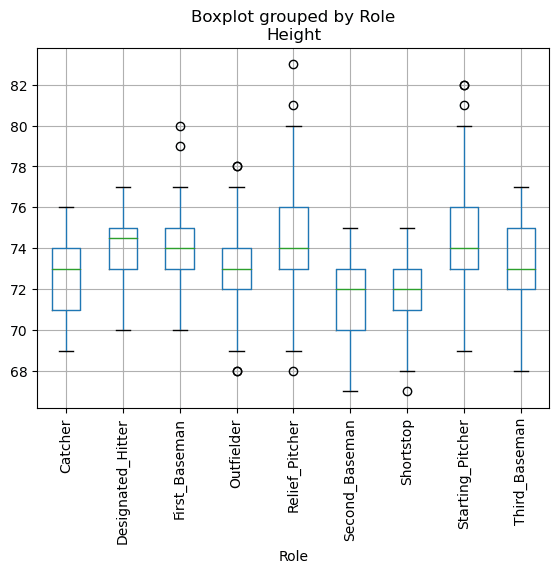

به صورت گرافیکی میتوانیم رابطه بین میانه و چارکها را در یک نمودار به نام جعبه نمودار نشان دهیم:

در اینجا ما همچنین محدوده بین چارکی IQR=Q3-Q1 و به اصطلاح دور افتادهها - مقادیری که خارج از مرزهای [Q1-1.5 IQR,Q3+1.5IQR] قرار دارند را محاسبه میکنیم.

برای توزیع محدود که حاوی تعداد کمی از مقادیر ممکن است، یک "مقدار معمول" خوب مقداری است که بیشتر از همه ظاهر میشود، که به آن مد میگویند. اغلب برای دادههای دستهای، مانند رنگها، اعمال میشود. به عنوان مثال، وقتی دو گروه از افراد داریم - برخی که قرمز را ترجیح میدهند و برخی دیگر که آبی را ترجیح میدهند. اگر رنگها را با اعداد کد کنیم، مقدار میانگین برای رنگ مورد علاقه در طیف نارنجی-سبز خواهد بود، که نشان دهنده ترجیح واقعی در هیچ یک از گروهها نیست. با این حال، مد یکی از رنگها یا هر دو رنگ خواهد بود، اگر تعداد افرادی که به آنها رأی میدهند برابر باشد (در این صورت نمونه را چند مدی مینامیم).

دادههای دنیای واقعی

هنگامی که ما دادههای دنیای واقعی را تحلیل میکنیم، اغلب آنها متغیرهای تصادفی به معنای واقعی نیستند، به این معنا که ما آزمایشهایی با نتیجه نامعلوم انجام نمیدهیم. برای مثال، یک تیم از بازیکنان بیسبال و دادههای بدنی آنها مانند قد، وزن و سن را در نظر بگیرید. این اعداد دقیقاً تصادفی نیستند، اما همچنان میتوانیم همان مفاهیم ریاضی را اعمال کنیم. برای مثال، یک دنباله از وزن افراد را میتوان به عنوان یک دنباله از مقادیر گرفته شده از برخی متغیرهای تصادفی در نظر گرفت. در زیر دنبالهای از وزن بازیکنان بیسبال واقعی از Major League Baseball است که از این مجموعه داده گرفته شده است (برای راحتی شما، فقط ۲۰ مقدار اول نشان داده شده است):

[180.0, 215.0, 210.0, 210.0, 188.0, 176.0, 209.0, 200.0, 231.0, 180.0, 188.0, 180.0, 185.0, 160.0, 180.0, 185.0, 197.0, 189.0, 185.0, 219.0]

توجه: برای مشاهده مثال کار با این مجموعه داده، به دفترچه همراه نگاهی بیندازید. همچنین در طول این درس تعدادی چالش وجود دارد و میتوانید با افزودن مقداری کد به آن دفترچه، آنها را تکمیل کنید. اگر مطمئن نیستید که چگونه با دادهها کار کنید، نگران نباشید - ما بعداً به کار با دادهها با استفاده از پایتون باز خواهیم گشت. اگر نمیدانید چگونه کد را در Jupyter Notebook اجرا کنید، به این مقاله نگاهی بیندازید.

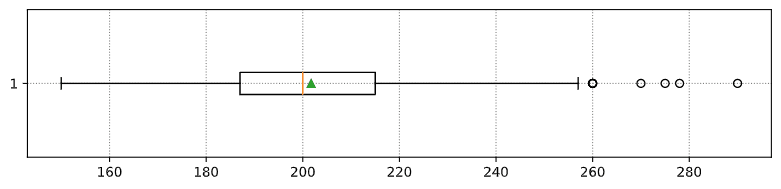

در اینجا نمودار جعبهای نشاندهنده میانگین، میانه و چارک برای دادههای ما است:

از آنجایی که دادههای ما حاوی اطلاعاتی در مورد نقشهای مختلف بازیکن است، میتوانیم نمودار جعبهای را بر اساس نقش نیز انجام دهیم - این به ما امکان میدهد ایدههایی در مورد نحوه تفاوت مقادیر پارامترها در نقشها به دست آوریم. این بار قد را در نظر میگیریم:

این نمودار نشان میدهد که به طور میانگین، قد اولین بازیکنان پایه از قد دومین بازیکنان پایه بالاتر است. بعداً در این درس یاد خواهیم گرفت که چگونه این فرضیه را به طور رسمیتر آزمایش کنیم و چگونه نشان دهیم که دادههای ما از نظر آماری معنیدار هستند تا این موضوع را نشان دهند.

هنگام کار با دادههای دنیای واقعی، فرض میکنیم که همه نقاط داده نمونهای از برخی توزیعهای احتمالی هستند. این فرض به ما امکان میدهد تکنیکهای یادگیری ماشین را اعمال کنیم و مدلهای پیشبینیکننده کارآمد بسازیم.

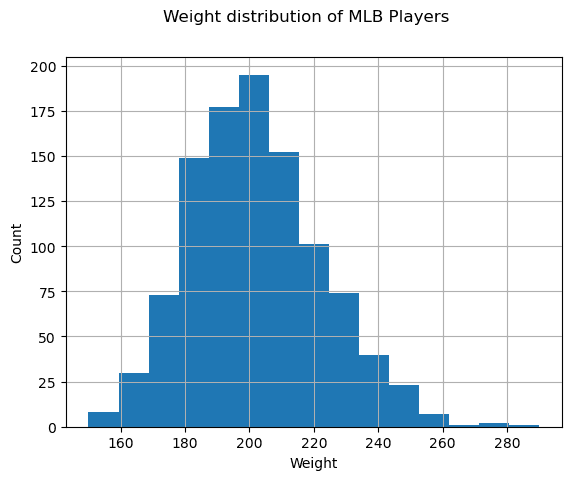

برای دیدن توزیع دادههایمان، میتوانیم نموداری به نام هیستوگرام رسم کنیم. محور X حاوی تعدادی از فواصل وزن مختلف (به اصطلاح بین) خواهد بود و محور عمودی تعداد دفعاتی را که نمونه متغیر تصادفی ما در یک فاصله معین قرار داشت نشان میدهد.

از این هیستوگرام میتوانید ببینید که تمام مقادیر حول میانگین وزن مشخصی متمرکز هستند و هرچه از آن وزن دورتر شویم، وزنهای کمتری با آن مقدار مواجه میشوند. یعنی، بسیار بعید است که وزن یک بازیکن بیسبال بسیار متفاوت از میانگین وزن باشد. واریانس وزنها نشان میدهد که وزنها تا چه حد احتمال دارد از میانگین متفاوت باشند.

اگر وزن افراد دیگر را در نظر بگیریم، نه از لیگ بیسبال، توزیع احتمالاً متفاوت خواهد بود. با این حال، شکل توزیع یکسان خواهد بود، اما میانگین و واریانس تغییر خواهند کرد. بنابراین، اگر مدل خود را روی بازیکنان بیسبال آموزش دهیم، احتمالاً هنگام اعمال روی دانشجویان یک دانشگاه، نتایج نادرستی میدهد، زیرا توزیع زیربنایی متفاوت است.

توزیع نرمال

توزیع وزنهایی که در بالا دیدیم بسیار معمول است و بسیاری از اندازهگیریها از دنیای واقعی از همان نوع توزیع پیروی میکنند، اما با میانگین و واریانس متفاوت. این توزیع به نام توزیع نرمال نامیده میشود و در آمار نقش بسیار مهمی دارد.

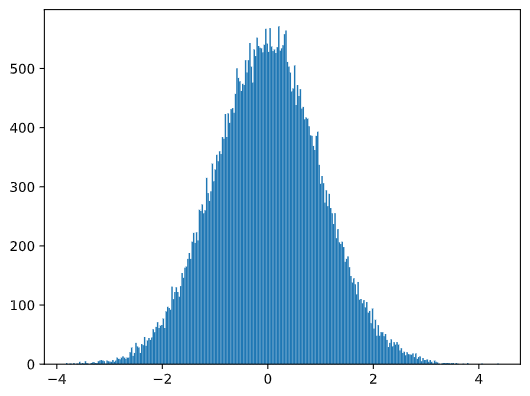

استفاده از توزیع نرمال یک راه صحیح برای تولید وزنهای تصادفی بازیکنان بیسبال بالقوه است. هنگامی که میانگین وزن mean و

انحراف استاندارد std را میدانیم، میتوانیم 1000 نمونه وزن را به روش زیر تولید کنیم:

samples = np.random.normal(mean,std,1000)

اگر هیستوگرام نمونههای تولید شده را رسم کنیم، تصویری بسیار شبیه به تصویر بالا را خواهیم دید. و اگر تعداد نمونهها و تعداد bins را افزایش دهیم، میتوانیم تصویری از یک توزیع نرمال که به ایدهآل نزدیکتر است، تولید کنیم:

توزیع نرمال با میانگین=0 و انحراف استاندارد=1

فاصله اطمینان

هنگامی که در مورد وزن بازیکنان بیسبال صحبت میکنیم، فرض میکنیم که یک متغیر تصادفی W وجود دارد که به توزیع احتمال ایدهآل وزن همه بازیکنان بیسبال (به اصطلاح جمعیت) مربوط میشود. توالی وزنهای ما مربوط به زیرمجموعهای از همه بازیکنان بیسبال است که ما آن را نمونه مینامیم. یک سوال جالب این است که آیا میتوانیم پارامترهای توزیع W، یعنی میانگین و واریانس جمعیت را بدانیم؟

سادهترین پاسخ این است که میانگین و واریانس نمونه خود را محاسبه کنیم. با این حال، ممکن است نمونه تصادفی ما جمعیت کامل را به دقت نشان ندهد. بنابراین صحبت در مورد فاصله اطمینان معنا دارد.

فاصله اطمینان تخمینی از میانگین واقعی جمعیت با توجه به نمونه ما است، که با احتمال خاصی (یا سطح اطمینان) دقیق است.

فرض کنید ما یک نمونه X1, ..., Xn از توزیع خود داریم. هر بار که یک نمونه از توزیع خود میگیریم، با مقدار میانگین متفاوت μ مواجه میشویم. بنابراین μ را میتوان یک متغیر تصادفی در نظر گرفت. یک فاصله اطمینان با اطمینان p یک جفت مقدار (Lp,Rp) است، به طوری که P(Lp≤μ≤Rp) = p، یعنی احتمال اینکه مقدار میانگین اندازهگیری شده در فاصله قرار گیرد برابر با p است.

بحث دقیق در مورد نحوه محاسبه این فواصل اطمینان از حوصله این مقدمه کوتاه خارج است. برخی از جزئیات بیشتر را میتوانید در ویکیپدیا بیابید. به طور خلاصه، ما توزیع میانگین نمونه محاسبه شده نسبت به میانگین واقعی جمعیت را تعریف میکنیم، که به نام توزیع استیودنت نامیده میشود.

واقعیت جالب: توزیع استیودنت به نام ریاضیدان ویلیام سیل گوست نامگذاری شده است، که مقاله خود را تحت نام مستعار " استیودنت" منتشر کرد. او در کارخانه گینس کار میکرد و طبق یکی از نسخهها، کارفرمای او نمیخواست عموم مردم بدانند که آنها از آزمونهای آماری برای تعیین کیفیت مواد خام استفاده میکنند.

اگر بخواهیم میانگین μ جمعیت خود را با اطمینان p تخمین بزنیم، باید (1-p)/2-امین صدک توزیع استیودنت A را بگیریم، که میتوان آن را از جداول یا با استفاده از برخی توابع داخلی نرمافزار آماری (مانند پایتون، R و غیره) محاسبه کرد. سپس فاصله برای μ با X±A*D/√n داده میشود، که X میانگین به دست آمده از نمونه، D انحراف استاندارد است.

توجه: ما همچنین بحث در مورد یک مفهوم مهم درجه آزادی را که در رابطه با توزیع استیودنت مهم است، حذف میکنیم. میتوانید برای درک عمیقتر این مفهوم به کتابهای کاملتری در مورد آمار مراجعه کنید.

یک مثال از محاسبه فاصله اطمینان برای وزنها و قدها در دفترچههای همراه ارائه شده است.

| p | میانگین وزن |

|---|---|

| 0.85 | 201.73±0.94 |

| 0.90 | 201.73±1.08 |

| 0.95 | 201.73±1.28 |

توجه داشته باشید که هرچه احتمال اطمینان بیشتر باشد، فاصله اطمینان گستردهتر است.

آزمون فرضیه

در مجموعه داده بازیکنان بیسبال ما، نقشهای مختلفی برای بازیکنان وجود دارد که میتوان آنها را به صورت زیر خلاصه کرد ( به دفترچه همراه نگاه کنید تا ببینید چگونه این جدول محاسبه شده است):

| نقش | قد | وزن | تعداد |

|---|---|---|---|

| گیرنده | 72.723684 | 204.328947 | 76 |

| ضربه زن تعیین شده | 74.222222 | 220.888889 | 18 |

| اولین بازیکن پایه | 74.000000 | 213.109091 | 55 |

| بازیکن خارجی | 73.010309 | 199.113402 | 194 |

| پرتاب کننده کمکی | 74.374603 | 203.517460 | 315 |

| دومین بازیکن پایه | 71.362069 | 184.344828 | 58 |

| shortstop | 71.903846 | 182.923077 | 52 |

| پرتاب کننده شروع کننده | 74.719457 | 205.163636 | 221 |

| سومین بازیکن پایه | 73.044444 | 200.955556 | 45 |

ما میتوانیم متوجه شویم که میانگین قد اولین بازیکنان پایه از میانگین قد دومین بازیکنان پایه بیشتر است. بنابراین، ممکن است وسوسه شویم که نتیجه بگیریم اولین بازیکنان پایه از دومین بازیکنان پایه بلندتر هستند.

این جمله یک فرضیه نامیده میشود، زیرا ما نمیدانیم که آیا این واقعیت واقعاً درست است یا نه.

با این حال، همیشه واضح نیست که آیا میتوانیم این نتیجهگیری را انجام دهیم یا نه. از بحث بالا میدانیم که هر میانگین یک فاصله اطمینان مرتبط دارد و بنابراین این تفاوت میتواند فقط یک خطای آماری باشد. ما به راهی رسمیتر برای آزمایش فرضیه خود نیاز داریم.

بیایید فاصلههای اطمینان را جداگانه برای قد اولین و دومین بازیکنان پایه محاسبه کنیم:

| اطمینان | اولین بازیکنان پایه | دومین بازیکنان پایه |

|---|---|---|

| 0.85 | 73.62..74.38 | 71.04..71.69 |

| 0.90 | 73.56..74.44 | 70.99..71.73 |

| 0.95 | 73.47..74.53 | 70.92..71.81 |

ما میتوانیم ببینیم که تحت هیچ اطمینانی فاصلهها همپوشانی ندارند. این فرضیه ما را ثابت میکند که اولین بازیکنان پایه از دومین بازیکنان پایه بلندتر هستند.

به طور رسمیتر، مسئلهای که ما در حال حل آن هستیم این است که ببینیم آیا دو توزیع احتمال یکسان هستند، یا حداقل پارامترهای یکسانی دارند. بسته به توزیع، ما نیاز داریم که از آزمونهای مختلفی برای آن استفاده کنیم. اگر ما میدانیم که توزیعهای ما نرمال هستند، میتوانیم آزمون تی استیودنت را اعمال کنیم.

در آزمون تی استیودنت، ما به اصطلاح t-value را محاسبه میکنیم، که نشان دهنده تفاوت بین میانگینها با در نظر گرفتن واریانس است. نشان داده شده است که t-value از توزیع استیودنت پیروی میکند، که به ما اجازه میدهد تا مقدار آستانه را برای یک سطح اطمینان داده شده p به دست آوریم (این میتواند محاسبه شود، یا در جداول عددی جستجو شود). سپس ما t-value را با این آستانه مقایسه میکنیم تا فرضیه را تایید یا رد کنیم.

در پایتون، ما میتوانیم از بسته SciPy استفاده کنیم، که شامل تابع ttest_ind (علاوه بر بسیاری از توابع آماری مفید

دیگر!) است. این تابع t-value را برای ما محاسبه میکند، و همچنین جستجوی معکوس مقدار اطمینان p-value را انجام میدهد، به

طوری که ما میتوانیم فقط به اطمینان نگاه کنیم تا نتیجهگیری کنیم.

برای مثال، مقایسه ما بین قد اولین و دومین بازیکنان پایه نتایج زیر را به ما میدهد:

from scipy.stats import ttest_ind

tval, pval = ttest_ind(df.loc[df['Role']=='First_Baseman',['Height']], df.loc[df['Role']=='Designated_Hitter',['Height']],equal_var=False)

print(f"T-value = {tval[0]:.2f}\nP-value: {pval[0]}")

T-value = 7.65

P-value: 9.137321189738925e-12

در مورد ما، p-value بسیار پایین است، به این معنی که شواهد قوی وجود دارد که نشان میدهد اولین بازیکنان پایه بلندتر هستند.

همچنین انواع دیگری از فرضیههایی وجود دارند که ممکن است بخواهیم آزمایش کنیم، برای مثال:

- برای اثبات اینکه یک نمونه داده شده از یک توزیع پیروی میکند. در مورد ما، ما فرض کردهایم که قدها به صورت نرمال توزیع شدهاند، اما این نیاز به تأیید آماری رسمی دارد.

- برای اثبات اینکه یک میانگین نمونه با یک مقدار از پیش تعریف شده مطابقت دارد.

- برای مقایسه میانگینهای تعدادی از نمونهها (به عنوان مثال، تفاوت در سطوح شادی در بین گروههای سنی مختلف چیست).

قانون اعداد بزرگ و قضیه حد مرکزی

یکی از دلایلی که توزیع نرمال بسیار مهم است، به اصطلاح قضیه حد مرکزی است. فرض کنید ما یک نمونه بزرگ از مقادیر مستقل N به صورت X1, ..., XN داریم که از هر توزیعی با میانگین μ و واریانس σ2 نمونهگیری شدهاند. سپس، برای N به اندازه کافی بزرگ (به عبارت دیگر، وقتی N→∞)، میانگین ΣiXi به صورت نرمال توزیع میشود، با میانگین μ و واریانس σ2/N.

راه دیگر برای تفسیر قضیه حد مرکزی این است که بگوییم صرف نظر از توزیع، هنگامی که میانگین مجموع هر مقدار متغیر تصادفی را محاسبه میکنید، در نهایت با توزیع نرمال مواجه میشوید.

از قضیه حد مرکزی همچنین نتیجه میشود که، وقتی N→∞، احتمال اینکه میانگین نمونه برابر با μ باشد، 1 میشود. این به عنوان قانون اعداد بزرگ شناخته میشود.

کوواریانس و همبستگی

یکی از کارهایی که علم داده انجام میدهد، پیدا کردن روابط بین دادهها است. ما میگوییم که دو دنباله همبستگی دارند، هنگامی که آنها رفتار مشابهی را در یک زمان نشان میدهند، یعنی آنها یا همزمان افزایش/کاهش مییابند، یا یک دنباله افزایش مییابد در حالی که دیگری کاهش مییابد و برعکس. به عبارت دیگر، به نظر میرسد که بین دو دنباله یک رابطه وجود دارد.

همبستگی لزوماً نشان دهنده رابطه علی بین دو دنباله نیست؛ گاهی اوقات هر دو متغیر میتوانند به یک علت خارجی وابسته باشند، یا ممکن است کاملاً تصادفی باشد که دو دنباله همبستگی دارند. با این حال، همبستگی ریاضی قوی نشان دهنده خوبی است که دو متغیر به نوعی به هم مرتبط هستند.

از نظر ریاضی، مفهوم اصلی که رابطه بین دو متغیر تصادفی را نشان میدهد، کوواریانس است که به این صورت محاسبه میشود: Cov(X,Y) = E$$(X-E(X))(Y-E(Y))$$. ما انحراف هر دو متغیر از مقادیر میانگین آنها را محاسبه میکنیم، و سپس حاصلضرب آن انحرافات را به دست میآوریم. اگر هر دو متغیر با هم انحراف پیدا کنند، حاصلضرب همیشه یک مقدار مثبت خواهد بود که به کوواریانس مثبت اضافه میشود. اگر هر دو متغیر خارج از همگامسازی انحراف پیدا کنند (یعنی یکی زیر میانگین کاهش مییابد در حالی که دیگری بالای میانگین افزایش مییابد)، همیشه اعداد منفی به دست میآوریم که به کوواریانس منفی اضافه میشوند. اگر انحرافات وابسته نباشند، آنها تقریباً به صفر اضافه میشوند.

مقدار مطلق کوواریانس به ما نمیگوید که همبستگی چقدر بزرگ است، زیرا به بزرگی مقادیر واقعی بستگی دارد. برای نرمالسازی آن، میتوانیم کوواریانس را بر انحراف معیار هر دو متغیر تقسیم کنیم تا همبستگی را به دست آوریم. نکته خوب این است که همبستگی همیشه در محدوده [-1,1] قرار دارد، جایی که 1 نشان دهنده همبستگی مثبت قوی بین مقادیر، -1 - همبستگی منفی قوی و 0 - هیچ همبستگی (متغیرها مستقل هستند) است.

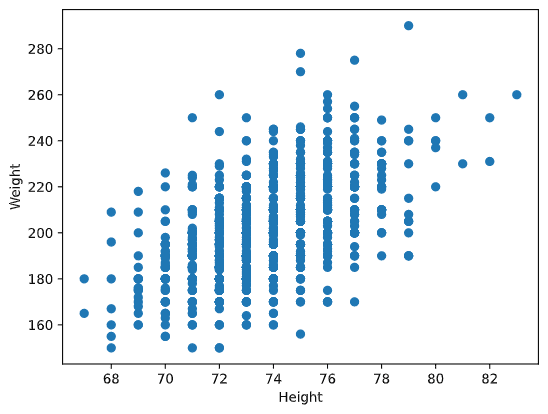

مثال: ما میتوانیم همبستگی بین وزنها و قدهای بازیکنان بیسبال را از مجموعه دادههای ذکر شده در بالا محاسبه کنیم:

print(np.corrcoef(weights,heights))

در نتیجه، ما ماتریس همبستگی مانند این را به دست میآوریم:

array([[1. , 0.52959196],

[0.52959196, 1. ]])

ماتریس همبستگی C را میتوان برای هر تعداد دنباله ورودی S1، ...، Sn محاسبه کرد. مقدار C ij همبستگی بین Si و Sj است و عناصر قطر اصلی همیشه 1 هستند (که همچنین خودهمبستگی S i است).

در مورد ما، مقدار 0.53 نشان میدهد که بین وزن و قد یک شخص همبستگی وجود دارد. ما همچنین میتوانیم نمودار پراکندگی یک مقدار در برابر دیگری را برای مشاهده بصری رابطه ایجاد کنیم:

نمونههای بیشتری از همبستگی و کوواریانس را میتوانید در دفترچه همراه بیابید.

نتیجهگیری

در این بخش، ما آموختیم:

- خواص آماری پایه دادهها، مانند میانگین، واریانس، مد و چارکها

- توزیعهای مختلف متغیرهای تصادفی، از جمله توزیع نرمال

- چگونه همبستگی بین خواص مختلف را پیدا کنیم

- چگونه از دستگاه صوتی ریاضی و آمار برای اثبات برخی فرضیات استفاده کنیم،

- چگونه فاصله اطمینان برای متغیر تصادفی با توجه به نمونه داده را محاسبه کنیم

در حالی که این قطعاً لیست کاملی از موضوعات موجود در احتمال و آمار نیست، باید برای شروع خوب در این دوره کافی باشد.

🚀 چالش

از نمونه کد در دفترچه برای آزمایش سایر فرضیههایی که استفاده کنید:

- اولین بازیکنان پایه از دومین بازیکنان پایه مسنتر هستند

- اولین بازیکنان پایه از سومین بازیکنان پایه بلندتر هستند

- شورتاستاپها از دومین بازیکنان پایه بلندتر هستند

آزمون پس از سخنرانی

مرور و خودآموزی

آمار و احتمال موضوعی بسیار گسترده است که شایسته دوره خاص خود است. اگر علاقه مند به مطالعه عمیق تر در تئوری هستید، ممکن است بخواهید به خواندن برخی از کتاب های زیر ادامه دهید:

- کارلوس فرناندز-گراندا از دانشگاه نیویورک دارای یادداشت های سخنرانی عالی احتمال و آمار برای علم داده (به صورت آنلاین در دسترس است)

- پیتر و اندرو بروس. آمار عملی برای دانشمندان داده. [نمونه کد در R].

- جیمز دی. میلر. آمار برای علم داده [نمونه کد در R]

تکلیف

اعتبارات

این درس با ♥️ توسط دیمیتری سوشنیکوف تألیف شده است.